728x90

RNN 구현

RNN 계층 구현

import numpy as np

class RNN:

def __init__(self, Wx, Wh, b):

self.params = [Wx, Wh, b]

self.grads = [np.zeros_like(Wx), np.zeros_like(Wh), np.zeros_like(b)]

self.cache = None

def forward(self, x, h_prev):

Wx, Wh, b = self.params

t = np.matmul(h_prev, Wh) + np.matmul(x, Wx) + b

h_next = np.tanh(t)

self.cache = (x, h_prev, h_next)

return h_next

def backward(self, dh_next):

Wx, Wh, b = self.cache

dt = dh_next * (1 - h_enxt ** 2)

db = np.sum(dt, axis = 0)

dWh = np.matmul(h_prev.T, dt)

dh_prev = np.matmul(dt, Wh.T)

dWx = np.matmul(x.T, dt)

dx = np.matmul(dt, Wx.T)

self.grads[0][...] = dWx

self.grads[1][...] = dWh

self.grads[2][...] = db

return dx, dh_prevTime RNN 계층 구현

class TimeRNN:

def __init__(self, Wx, Wh, b, stateful = False):

self.params = [Wx, Wh, b]

self.grads = [np.zeros_like(Wx), np.zeros_like(Wh), np.zeros_like(b)]

self.layers = None

self.h, self.dh = None, None

self.stateful = stateful

def set_state(self, h):

self.h = h

def reset_state(self):

self.h = None

def forward(self, xs):

Wx, Wh, b = self.params

N, T, D = xs.shape

D, H = Wx.shape

self.layers = []

hs = np.empty((N, T, H), dtype = 'f')

if not self.stateful or self.h is None:

self.h = np.zeros((N, H), dtype = 'f')

for t in range(T):

layer = RNN(*self.params)

self.h = layer.forward(xs[:, t, :], self.h)

hs[:, t, :] = self.h

self.layers.append(layer)

return hs

def backward(self, dhs):

Wx, Wh, b = self.params

N, T, H = dhs.shape

D, H = Wx.shape

dxs = np.empty((N, T, D), dtype = 'f')

dh = 0

grads = [0, 0, 0]

for t in reversed(range(T)):

layer = self.layers[t]

dx, dh = layer.backward(dhs[:, t, :] + dh) # 합산된 기울기

dxs[:, t, :] = dx

for i, grad in enumerate(layer.grads):

grads[i] += grad

for i, grad in enumerate(grads):

self.grads[i][...] = grad

self.dh = dh

return dxsRNNLM학습과 평가

RNNLM 구현

import sys

sys.path.append('..')

import numpy as np

from common.time_layers import *

class SimpleRnnlm:

def __init__(self, vocab_size, wordvec_size, hidden_size):

V, D, H = vocab_size, wordvec_size, hidden_size

rn = np.random.randn

# 가중치 초기화

embed_W = (rn(V, D) / 100).astype('f')

rnn_Wx = (rn(D, H) / np.sqrt(D)).astype('f')

rnn_Wh = (rn(H, H) / np.sqrt(H)).astype('f')

rnn_b = np.zeros('H').astype('f')

affine_W = (rn(H, V) / np.sqrt(H)).astype('f')

affine_b = np.zeros(V).astype('f')

# 계층 생성

self.layers = [

TimeEmbedding(embed_W),

TimeRNN(rnn_Wx, rnn_Wh, rnn_b, stateful = True),

TimeAffine(affine_W, affine_b)

]

self.loss_layer = TimeSoftmaxWithLoss()

self.rnn_layer = self.layers[1]

# 모든 가중치와 기울기를 리스트에 모은다.

self.params, self.grads = [], []

for layer in self.layers:

self.params += layer.params

self.grads += layer.grads

def forward(self, xs, ts):

for layer in self.layers:

xs = layer.forward(xs)

loss = self.loss_layer.forward(xs, ts)

return loss

def backward(self, dout = 1):

dout = self.loss_layer.bavkward(dout)

for layer in reversed(self.layers):

dout = layer.backward(dout)

return dout

def reset_state(self):

self.rnn_layer.reset_state()RNNLM의 학습 코드

import sys

sys.path.append('..')

import matplotlib.pyplot as plt

import numpy as np

from common.optimizer import SGD

from dataset import ptb

from ch05.simple_rnnlm import SimpleRnnlm

# 하이퍼파라미터 설정

batch_size = 10

wordvec_size = 100

hidden_size = 100 # RNN의 은닉 상태 벡터의 원소 수

time_size = 5 # Truncated BPTT가 한 번에 펼치는 시간 크기

lr = 0.1

max_epoch = 100

# 학습 데이터 읽기(전체 중 1000개만)

corpus, word_to_id, id_to_word = ptb.load_data('train')

corpus_size = 1000

corpus = corpus[:corpus_size]

vocab_size = int(max(corpus) + 1)

xs = corpus[:-1] # 입력

ts = corpus[1:] # 출력(정답 레이블)

data_size = len(xs)

print(f'말뭉치 크기: {corpus_size}, 어휘 수: {vocab_size}')

# 학습 시 사용하는 변수

max_iters = data_size // (batch_size * time_size)

time_idx = 0

total_loss = 0

loss_count = 0

ppl_list = []

# 모델 생성

model = SimpleRnnlm(vocab_size, wordvec_size, hidden_size)

optimizer = SGD(lr)

# 각 미니배치에서 샘플을 읽기 시작 위치를 계산

jump = (corpus_size - 1) // batch_size

offsets = [i * jump for i in range(batch_size)]

for epoch in range(max_epoch):

for iter in range(max_iters):

# 미니배치 획득

batch_x = np.empty((batch_size, time_size), dtype = 'i')

batch_t = np.empty((batch_size, time_size), dtype = 'i')

for t in range(time_size):

for i, offset in enumerate(offsets):

batch_x[i, t] = xs[(offset + time_idx) % data_size]

batch_t[i, t] = ts[(offset + time_idx) % data_size]

time_idx += 1

# 기울기를 구하여 매개변수 갱신

loss = model.forward(batch_x, batch_t)

model.backward()

optimizer.update(model.params, model.grads)

total_loss += loss

loss_count += 1

# 에폭마다 퍼플렉서티 평가

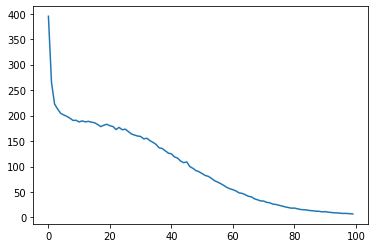

ppl = np.exp(total_loss / loss_count)

print(f'| 에폭 {epoch +1} | 퍼플렉서티 {ppl:.2f}')

ppl_list.append(float(ppl))

total_loss, loss_count = 0, 0그래프로 그리기

plt.plot(ppl_list)

RNNLM의 Trainer 클래스

import sys

sys.path.append('..')

from common.optimizer import SGD

from common.trainer import RnnlmTrainer

from dataset import ptb

from ch05.simple_rnnlm import SimpleRnnlm

# 하이퍼파라미터 설정

batch_size = 10

wordvec_size = 100

hidden_size = 100 # RNN의 은닉 상태 벡터의 원소 수

time_size = 5 # RNN을 펼치는 크기

lr = 0.1

max_epoch = 100

# 학습 데이터 읽기

corpus, word_to_id, id_to_word = ptb.load_data('train')

corpus_size = 1000 # 테스트 데이터셋을 작게 설정

corpus = corpus[:corpus_size]

vocab_size = int(max(corpus) + 1)

xs = corpus[:-1] # 입력

ts = corpus[1:] # 출력(정답 레이블)

# 모델 생성

model = SimpleRnnlm(vocab_size, wordvec_size, hidden_size)

optimizer = SGD(lr)

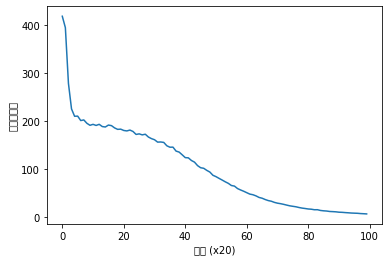

trainer = RnnlmTrainer(model, optimizer)

trainer.fit(xs, ts, max_epoch, batch_size, time_size)

trainer.plot()그래프

정리

- RNN은 순환하는 경로가 있고, 이를 통해 내부에 '은닉 상태'를 기억할 수 있다.

- RNN의 순환 경로를 펼침으로써 다수의 RNN 계층이 연결된 신경망으로 해석할 수 있으며, 보통의 오차역전파법으로 학습할 수 있다.(=BPTT)

- 긴 시계열 데이터를 학습할 때는 데이터를 적당한 길이씩 모으고(이를 '블록'이라 한다.), 블록 단위로 BPTT에 의한 학습을 수행한다.(=Truncated BPTT)

- Truncated BPTT에서는 역전파의 연결만 끊는다.

- Truncated BPRR에서는 순전파의 연결을 유지하기 위해 데이터를 '순차적'으로 입력해야 한다.

- 언어 모델은 단어 스퀀스를 확률로 해석한다.

- RNN 계층을 이용한 조건부 언어 모델은 (이론적으로는) 그때까지 등장한 모든 단어의 정보를 기억할 수 있다.

- 출처: 밑바닥부터 시작하는 딥러닝2

- notebook ipynb file:

GitHub - heejvely/Deep_learning: deep learning 기초 공부

deep learning 기초 공부. Contribute to heejvely/Deep_learning development by creating an account on GitHub.

github.com

728x90

'Deep Learning' 카테고리의 다른 글

| [Deep Learning] 모델 설계하기 (0) | 2022.12.30 |

|---|---|

| [Deep Learning] 프레임워크 확장 코드 구현 (0) | 2022.11.24 |

| [Deep Learning] 딥러닝 클래스 코드 구현(연산, layer, neuralnetwork, 배치학습, optimizer) (0) | 2022.11.23 |

| [Deep Learning] 오차 수정하기: 경사하강법, 편미분 코드 구현 (0) | 2022.11.22 |

| [Deep Learning]퍼셉트론(Perceptron) (0) | 2022.11.16 |